La refonte d’un site critique est moins une évolution qu’une opération à cœur ouvert pour votre business, où la moindre erreur peut être fatale.

- Le SEO n’est pas une option mais le système sanguin du projet : le couper, même brièvement, entraîne des conséquences irréversibles sur votre visibilité et votre chiffre d’affaires.

- Chaque élément (URL, contenu, architecture) est un organe vital. Modifier l’un d’eux sans protocole strict, c’est risquer le rejet par Google et la fuite de vos clients.

Recommandation : Adoptez une méthodologie chirurgicale où chaque étape est planifiée, testée et validée de manière indépendante avant de procéder à la « transplantation » finale sur le serveur de production.

Pour tout directeur marketing, le projet de refonte d’un site web majeur est une double promesse. C’est l’opportunité de moderniser l’image de marque, d’améliorer l’expérience utilisateur et de s’aligner sur les nouvelles technologies. Mais derrière cette perspective enthousiasmante se cache une crainte profonde, celle de la catastrophe industrielle : un classement Google qui s’effondre, un trafic organique qui s’évapore et des clients qui ne trouvent plus leurs produits. Votre site actuel, bien que vieillissant, est un actif qui génère de la valeur chaque jour. Le toucher, c’est prendre un risque calculé.

L’approche commune se concentre souvent sur les aspects visibles : un nouveau design, une navigation plus intuitive. On dresse des listes de contrôle mentionnant les fameuses redirections 301 ou l’importance d’un audit technique. Pourtant, ces conseils, aussi justes soient-ils, ne capturent pas la criticité de l’opération. Ils décrivent les outils, pas la philosophie du chirurgien. Car la véritable clé du succès n’est pas dans une simple checklist, mais dans l’adoption d’un état d’esprit radicalement différent.

Et si la refonte d’un site critique n’était pas un projet de design ou de développement, mais une véritable transplantation d’organe numérique ? Chaque composant – l’architecture, les milliers de pages de contenu, la structure des URL, l’historique de référencement – est un tissu vivant, irrigué par le « jus SEO » accumulé au fil des ans. Le déplacer sans précaution, c’est risquer un rejet immédiat par l’écosystème Google et la perte de la confiance de vos utilisateurs. Cette perspective change tout. Elle impose une méthodologie où la prudence, la planification et la validation priment sur la vitesse.

Cet article n’est pas une simple liste de tâches. C’est un guide stratégique qui vous fournira le cadre de pensée et les protocoles méthodiques pour piloter cette opération à haut risque. Nous allons détailler, étape par étape, comment préparer le patient (votre site), réaliser la greffe (la migration) et surveiller les signaux vitaux post-opératoires pour garantir une convalescence rapide et un succès durable.

Sommaire : La méthodologie complète pour une migration de site web réussie

- Pourquoi oublier une seule redirection 301 peut vous coûter votre meilleure position Google ?

- Faut-il migrer les actualités d’il y a 5 ans : comment faire le tri sans regrets ?

- Comment recetter un site en staging pour détecter les bugs avant vos visiteurs ?

- Les 3 heures qui suivent la mise en ligne : que surveiller en priorité pour éviter le crash ?

- L’erreur de changer la structure de vos URL juste pour faire « plus joli »

- SaaS ou Headless : quelle architecture choisir pour gérer 50 000 références ?

- Pourquoi votre cadenas vert disparaît-il sur certaines pages et comment le réparer en 5 minutes ?

- L’audit technique indispensable pour les sites de plus de 1000 pages

Pourquoi oublier une seule redirection 301 peut vous coûter votre meilleure position Google ?

Imaginez que l’URL d’une de vos pages les plus performantes est une adresse postale. C’est à cette adresse que Google, vos clients et tous les sites qui vous font des liens (backlinks) envoient du « courrier » de valeur : de la notoriété, du trafic et de la confiance. La redirection 301 est simplement le formulaire de réexpédition que vous laissez à La Poste pour indiquer votre nouvelle adresse de manière permanente. Oublier de mettre en place cette redirection sur une URL stratégique, c’est comme démolir votre maison sans laisser de mot. Tout le courrier de valeur est renvoyé à l’expéditeur ou, pire, se perd à jamais.

En termes de SEO, la conséquence est immédiate et brutale. La nouvelle page, même si son contenu est identique, repart de zéro. Elle n’hérite d’aucune de l’autorité (le « PageRank » ou « jus SEO ») accumulée par l’ancienne. Pour Google, l’ancienne page est simplement devenue une erreur 404 (« N’existe plus »), et la nouvelle est une inconnue sans historique. Votre positionnement, patiemment construit sur cette page, s’effondre. C’est une hémorragie de notoriété qui peut prendre des mois à cicatriser, si tant est qu’elle le fasse un jour. La rigueur n’est pas une option : chaque URL qui change doit avoir son plan de redirection. C’est le fondement même de la survie SEO d’une refonte.

Cette règle est si fondamentale que les experts de Google la rappellent sans cesse. Comme le souligne clairement John Mueller, figure de proue du Google Search Central :

Si vous déplacez du contenu vers une nouvelle URL, vous devez configurer une redirection 301. C’est le seul moyen pour Google de comprendre que le contenu a été déplacé de façon permanente et de transférer les signaux de classement.

– John Mueller, Google Search Central Office Hours

L’oubli d’une seule redirection sur une page générant 10% de votre trafic organique n’est pas un détail technique, c’est une décision qui ampute directement votre chiffre d’affaires. C’est pourquoi le mapping exhaustif des URL et leur plan de redirection est la première étape, non-négociable, de toute « transplantation numérique ».

Faut-il migrer les actualités d’il y a 5 ans : comment faire le tri sans regrets ?

Lors d’une refonte, la tentation est grande de tout vouloir conserver. Après tout, ce contenu a demandé du temps et des ressources. C’est une erreur stratégique majeure. Migrer l’intégralité d’un site, surtout s’il contient des années d’actualités, d’articles de blog ou de fiches produits obsolètes, revient à transplanter les tissus sains en même temps que les tissus nécrosés. Ce « poids mort » numérique a des conséquences directes : il dilue l’autorité de votre site, gaspille votre budget de crawl (le temps que Google alloue à l’exploration de vos pages) et peut dégrader l’expérience utilisateur avec des informations périmées.

La refonte est l’occasion parfaite pour réaliser un « content pruning », un élagage de contenu méthodique. L’objectif n’est pas de supprimer pour supprimer, mais de concentrer la force de votre site sur les actifs qui génèrent réellement de la valeur : trafic, backlinks, conversions ou pertinence pour la marque. Un contenu qui n’a généré aucune visite organique en un an et ne possède aucun lien externe de qualité n’est pas un actif, c’est un passif. Il nuit à la perception globale de la qualité de votre site par Google.

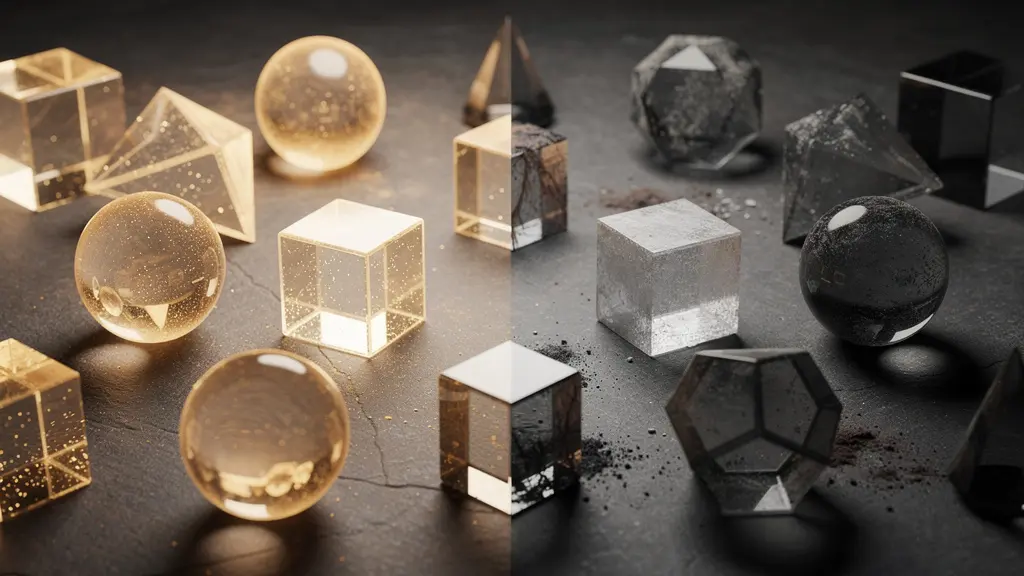

Cette sélection, comme le montre l’image ci-dessus, doit être délibérée et basée sur des données tangibles. Il s’agit de distinguer les joyaux qui méritent d’être polis et mis en valeur dans le nouvel écrin, de la poussière qui doit être nettoyée. Pour éviter les regrets, ce tri ne doit pas se faire au hasard mais suivre un protocole de décision strict, basé sur des indicateurs de performance clairs.

Pour vous guider dans ce processus critique, voici un plan d’action directement applicable. C’est votre protocole pour décider du sort de chaque page et vous assurer de ne conserver que le meilleur.

Votre plan d’action pour un élagage de contenu stratégique

- Analyse du trafic : Le contenu a-t-il généré du trafic organique au cours des 12 derniers mois ? Utilisez votre outil d’analyse pour isoler les pages « zombies ».

- Audit des backlinks : La page possède-t-elle des liens entrants (backlinks) provenant de domaines référents de qualité ? Un contenu sans trafic mais avec de bons liens a une valeur à préserver.

- Vérification de la pertinence : Le contenu est-il toujours factuellement exact, à jour et en phase avec le positionnement actuel de votre marque ? Une information obsolète peut nuire à votre crédibilité.

- Décision de redirection (si trafic nul mais backlinks forts) : Redirigez (301) la page vers un contenu thématiquement proche et plus performant pour transférer l’autorité des liens.

- Décision de suppression (si trafic nul et sans backlinks) : Supprimez la page et servez un code 410 (« Définitivement supprimé ») ou désindexez-la proprement pour indiquer à Google de ne plus la prendre en compte.

Comment recetter un site en staging pour détecter les bugs avant vos visiteurs ?

L’environnement de pré-production, ou « staging », est votre salle d’opération. C’est un clone du futur site où vous pouvez tester, analyser et corriger les bugs en toute sécurité avant la mise en ligne. Cependant, beaucoup d’équipes commettent l’erreur de ne réaliser qu’une recette fonctionnelle et visuelle, c’est-à-dire de vérifier que le site s’affiche bien et que les boutons fonctionnent. C’est nécessaire, mais dramatiquement insuffisant. Vous devez également recetter le site avec les yeux de Googlebot.

Le robot de Google ne « voit » pas le site comme un humain. Il est particulièrement sensible à la structure du code HTML, au temps de chargement des ressources et à la manière dont le contenu est rendu. Un menu de navigation qui apparaît parfaitement à l’utilisateur grâce à du JavaScript peut être totalement invisible pour Google s’il n’est pas présent dans le code source initial. C’est ce qu’on appelle une « disparité de rendu ». Recetter en staging, c’est donc mener une double investigation : l’une pour l’expérience utilisateur, l’autre pour l’indexabilité par les moteurs de recherche.

Le tableau suivant met en lumière quelques-unes des différences fondamentales entre ce que voit un visiteur et ce que peut percevoir Googlebot, surtout sur des sites modernes utilisant beaucoup de JavaScript.

| Élément testé | Rendu Navigateur (Utilisateur) | Rendu HTML Brut (Googlebot sans JS) |

|---|---|---|

| Menu de navigation | Visible au clic / Hover | Souvent absent si injecté en JS |

| Contenu principal | Chargement dynamique (Lazy load) | Vide si non présent dans le DOM initial |

| Méta-données (Title/Desc) | Mises à jour par le framework | Génériques par défaut si pas de SSR |

| Liens internes | Interactifs | Invisibles si balises <a> absentes |

Enfin, une règle d’or pour cette « salle d’opération » : elle doit être stérile et isolée. Un site en staging ne doit jamais être accessible aux moteurs de recherche. Le risque ? Que Google l’indexe par erreur, créant un contenu dupliqué massif avec votre site de production, une véritable infection SEO. Pour cela, la protection par mot de passe ou la restriction par adresse IP est impérative, comme le précise la documentation de Google Search : une simple instruction dans le fichier robots.txt est insuffisante, car elle peut être ignorée ou migrée par erreur lors du déploiement.

Les 3 heures qui suivent la mise en ligne : que surveiller en priorité pour éviter le crash ?

La mise en production du nouveau site n’est pas la fin du projet, c’est le début de la phase de surveillance critique. Les trois premières heures sont comparables à la période de réveil après une anesthésie générale. C’est à ce moment que les complications les plus graves peuvent survenir. Votre rôle est de vous transformer en anesthésiste-réanimateur, les yeux rivés sur les moniteurs pour détecter le moindre signal faible avant qu’il ne se transforme en arrêt cardiaque. Inutile de se disperser : trois signaux vitaux doivent être surveillés en priorité absolue.

Le premier est l’état du serveur. Surveillez en temps réel le taux d’erreurs (5xx pour les erreurs serveur, 4xx pour les erreurs client comme les 404). Une augmentation soudaine des erreurs 5xx peut indiquer que le nouveau site ne supporte pas la charge, tandis qu’un pic de 404 peut signaler un problème massif dans le plan de redirection. Des outils de monitoring serveur sont indispensables ici.

Le deuxième signal vital est l’activité de Googlebot. Via la Google Search Console (rapport « Statistiques sur l’exploration »), observez la fréquence à laquelle Google vient explorer votre site. Une chute drastique de l’activité du robot ou, à l’inverse, une explosion du temps de téléchargement moyen d’une page, sont des indicateurs d’un problème majeur. C’est le pouls de votre site aux yeux de Google.

Enfin, le troisième signal est la performance web (Core Web Vitals). Mesurez le LCP (Largest Contentful Paint) et le CLS (Cumulative Layout Shift) sur vos pages stratégiques. Un LCP qui explose peut signifier qu’une ressource critique (image, script) est trop lourde ou mal chargée, pénalisant immédiatement l’expérience utilisateur et votre score SEO. Cette vigilance de l’instant T permet d’intervenir et de corriger un problème en quelques minutes, avant qu’il n’impacte des milliers de visiteurs et ne soit enregistré durablement par Google.

L’erreur de changer la structure de vos URL juste pour faire « plus joli »

Dans un projet de refonte, l’une des tentations les plus courantes est de vouloir « nettoyer » la structure des URL. On se dit qu’une URL comme `/fr/c/categorie-1/p/produit-abc` serait plus « jolie » et « SEO-friendly » sous la forme `/produit-abc`. C’est l’une des erreurs les plus dommageables que vous puissiez commettre. Une URL n’est pas un élément de décoration, c’est l’identifiant unique et permanent d’une ressource sur le web. C’est son numéro de sécurité sociale, son empreinte digitale.

Changer la structure de vos URL, c’est forcer l’intégralité de vos pages à changer d’identité. Même avec des redirections 301 parfaites, vous imposez à Google un travail colossal de réapprentissage. Le moteur doit non seulement parcourir toutes les nouvelles URL, mais aussi traiter chaque redirection une par une, comprendre que le contenu a déménagé, et enfin, après un certain temps, transférer la « notoriété » de l’ancienne URL vers la nouvelle. Ce processus n’est ni instantané ni garanti à 100%. Il consomme un budget de crawl considérable et introduit une période de flottement et de risque où les performances peuvent chuter.

La règle d’or est donc la suivante : ne changez une URL que si vous y êtes absolument obligé (par exemple, si la structure technique change radicalement ou si le nom du produit est modifié). Ne le faites jamais pour des raisons purement esthétiques. L’impact négatif potentiel sur votre SEO est infiniment supérieur au gain supposé d’avoir une URL « plus propre ». La stabilité des identifiants est un gage de confiance pour Google. Toute modification de masse est un signal de perturbation qui déclenche une réévaluation complète de votre site.

Les URL sont des identifiants. Si vous les changez, vous changez l’identité de la page. Google doit réapprendre l’URL, ce qui prend du temps et comporte des risques.

– John Mueller, Google Webmaster Central Hangout

Considérez la structure de vos URL comme l’anatomie de votre site : on ne la modifie pas sans une raison médicale impérieuse. La préserver, c’est garantir une transition beaucoup plus fluide et sécurisée.

SaaS ou Headless : quelle architecture choisir pour gérer 50 000 références ?

Le choix de l’architecture technique est la fondation sur laquelle reposera tout votre nouvel édifice. Pour un site gérant un volume de références aussi important que 50 000 produits, ce choix n’est pas anodin, il est stratégique et a des implications directes sur la performance SEO et la flexibilité future. Les deux grandes approches modernes sont les plateformes SaaS (Software as a Service) comme Shopify ou BigCommerce, et les architectures Headless (ou découplées). Si les solutions SaaS offrent une grande simplicité de mise en œuvre, l’architecture Headless, souvent basée sur des frameworks JavaScript, pose un défi technique majeur pour le SEO : le rendu du contenu.

Il existe deux manières principales de générer le HTML d’une page : côté serveur (Server-Side Rendering, SSR) ou côté client (Client-Side Rendering, CSR). En SSR, le serveur envoie au navigateur (et à Googlebot) une page HTML déjà complète. C’est la méthode traditionnelle, ultra-rapide et parfaitement lisible par les moteurs de recherche. En CSR, le serveur envoie une coquille HTML quasi vide et un gros fichier JavaScript. C’est ensuite le navigateur du visiteur qui doit exécuter ce script pour « construire » la page. Pour Google, c’est un problème : cela demande une étape supplémentaire et coûteuse de rendu JavaScript, ce qui peut retarder, voire empêcher, une bonne indexation.

Pour un catalogue de 50 000 références, où la vitesse d’indexation des nouveaux produits et la performance sont cruciales, privilégier une architecture garantissant le SSR est une nécessité. Une solution Headless mal configurée en pur CSR est une condamnation à mort pour votre SEO. Le contenu risque d’être invisible pour Google, et le budget de crawl sera gaspillé à essayer de rendre des milliers de pages complexes.

Le tableau ci-dessous, inspiré par les recommandations de Google sur le rendu dynamique, résume les enjeux pour un directeur marketing.

| Critère | Server-Side Rendering (SSR) | Client-Side Rendering (CSR) |

|---|---|---|

| Indexation Google | Immédiate (HTML complet) | Différée (nécessite rendu JS) |

| Budget de Crawl | Optimisé (rapide) | Coûteux (ressources CPU élevées) |

| Performance (LCP) | Rapide (contenu prêt) | Lent (attente du JS) |

| Risque SEO | Faible | Élevé (contenu masqué) |

Pourquoi votre cadenas vert disparaît-il sur certaines pages et comment le réparer en 5 minutes ?

Le passage au HTTPS, symbolisé par le fameux cadenas dans la barre d’adresse, est aujourd’hui une norme absolue. C’est un signal de confiance pour vos visiteurs et un critère de classement pour Google. Cependant, lors d’une refonte, il est fréquent de voir ce cadenas disparaître sur certaines pages, remplacé par un avertissement de « connexion non sécurisée ». Ce phénomène, appelé « contenu mixte » (ou mixed content), est un bug sournois qui dégrade la confiance et peut nuire à votre SEO.

Le problème survient lorsqu’une page sécurisée (chargée en HTTPS) contient des ressources (comme des images, des scripts, des feuilles de style CSS) qui sont, elles, appelées via une URL non sécurisée (en HTTP). C’est comme installer une porte blindée (HTTPS) sur votre maison, mais laisser une fenêtre grande ouverte (la ressource en HTTP). Les navigateurs modernes, pour protéger l’utilisateur, bloquent souvent ces ressources non sécurisées ou affichent un avertissement proéminent. Pour un visiteur, le message est clair : « ce site n’est pas totalement sûr ».

Les conséquences sont doubles. D’une part, si la ressource bloquée est une image produit ou un script essentiel, la page peut apparaître « cassée » à l’utilisateur, ruinant l’expérience. D’autre part, c’est un signal de mauvaise qualité technique envoyé à Google. La cause est souvent une URL « en dur » dans le code ou dans un contenu issu de l’ancien site qui n’a pas été mise à jour lors de la migration. La solution la plus robuste consiste à s’assurer que toutes les ressources sont appelées en relatif (ex: `/images/mon-image.jpg`) ou en HTTPS. Pour une solution de fond, la mise en place de l’en-tête de sécurité HSTS (HTTP Strict Transport Security) sur votre serveur force le navigateur à n’accepter que les connexions HTTPS, empêchant ainsi le chargement de toute ressource HTTP.

Pour détecter ces erreurs, des outils de crawl comme Screaming Frog peuvent scanner votre site à la recherche d’URL en HTTP sur vos pages HTTPS. La correction est souvent rapide, mais la détection est cruciale pour maintenir un environnement de confiance irréprochable.

À retenir

- L’URL est sacrée : considérez-la comme un identifiant permanent. Ne la modifiez que par nécessité absolue, jamais par esthétisme.

- Le contenu est un actif, pas une collection : tout ce qui ne génère pas de trafic, de liens ou de pertinence est un poids mort qui doit être élagué ou redirigé.

- La surveillance n’est pas une option : les premières heures post-lancement sont une phase de réanimation où la surveillance des signaux vitaux (erreurs serveur, crawl, performance) est impérative.

L’audit technique indispensable pour les sites de plus de 1000 pages

Si la refonte est une opération chirurgicale, l’audit technique est le bilan de santé pré-opératoire complet. Pour un site de plus de 1000 pages, cet audit ne peut se contenter de survoler les points habituels. Il doit plonger en profondeur dans la structure pour identifier les pathologies qui, si elles sont migrées sur le nouveau site, continueront de nuire à sa performance. Quatre points de contrôle sont particulièrement critiques pour les sites de grande envergure.

Premièrement, l’analyse de la profondeur de crawl. Les pages les plus importantes de votre site (celles qui génèrent le plus de revenus ou de trafic) doivent être accessibles en un minimum de clics depuis la page d’accueil. Des études montrent que les pages qui nécessitent à 3 clics de profondeur depuis la page d’accueil reçoivent beaucoup moins de trafic organique. L’audit doit cartographier cette structure et la nouvelle architecture doit corriger ces défauts d’accessibilité.

Deuxièmement, la gestion des paramètres d’URL. Les sites e-commerce, avec leurs multiples filtres (couleur, taille, prix), peuvent générer des millions d’URL quasi-identiques (ex: `…&couleur=bleu&taille=M` et `…&taille=M&couleur=bleu`). Sans une gestion stricte via les balises canoniques ou le fichier robots.txt, ces facettes créent des « spider traps » qui piègent Googlebot et gaspillent l’intégralité de votre budget de crawl dans des pages sans valeur.

Troisièmement, la détection des chaînes de redirection et des pages orphelines. Une page A qui redirige vers B, qui redirige vers C, dilue la transmission de l’autorité à chaque saut. L’audit doit identifier ces chaînes pour les aplanir en une seule redirection (A vers C). De même, les pages orphelines (qui existent mais ne reçoivent aucun lien interne) sont des impasses pour Google et les utilisateurs. Elles doivent être réintégrées dans le maillage du site ou supprimées.

Enfin, comme le recommande Google pour la gestion des grands sites, la validation de l’implémentation des balises canoniques est cruciale pour indiquer clairement quelle est la version « maîtresse » d’une page et ainsi maîtriser la duplication de contenu. Ces points sont la base d’un audit à grande échelle :

- Vérifier la gestion des paramètres d’URL (facettes) pour éviter le ‘Spider Trap’.

- Analyser les chaînes de redirection (Redirect Chains) qui diluent le budget de crawl.

- Identifier et corriger les pages orphelines (présentes dans le sitemap mais non liées).

- Valider l’implémentation des balises canoniques pour gérer la duplication de contenu.

En adoptant cette méthodologie chirurgicale, vous transformez un projet à haut risque en une opportunité de croissance maîtrisée. L’étape suivante consiste à formaliser ce plan de migration avec vos équipes techniques et marketing, en utilisant ces principes comme garde-fous à chaque décision.

Questions fréquentes sur la refonte de site et le SEO

Qu’est-ce que le contenu mixte (Mixed Content) ?

Cela se produit lorsqu’une page HTML sécurisée (HTTPS) charge des ressources (images, scripts, styles) via un protocole non sécurisé (HTTP).

Pourquoi est-ce dangereux pour le SEO ?

Google bloque souvent le chargement de ces ressources, rendant la page incomplète ou ‘cassée’ aux yeux de l’utilisateur et du robot.

Comment forcer le passage en HTTPS ?

En utilisant l’en-tête de sécurité HSTS (HTTP Strict Transport Security) sur le serveur.